Ollama:零代码部署大模型,轻松玩转AI

一、Ollama下载和安装

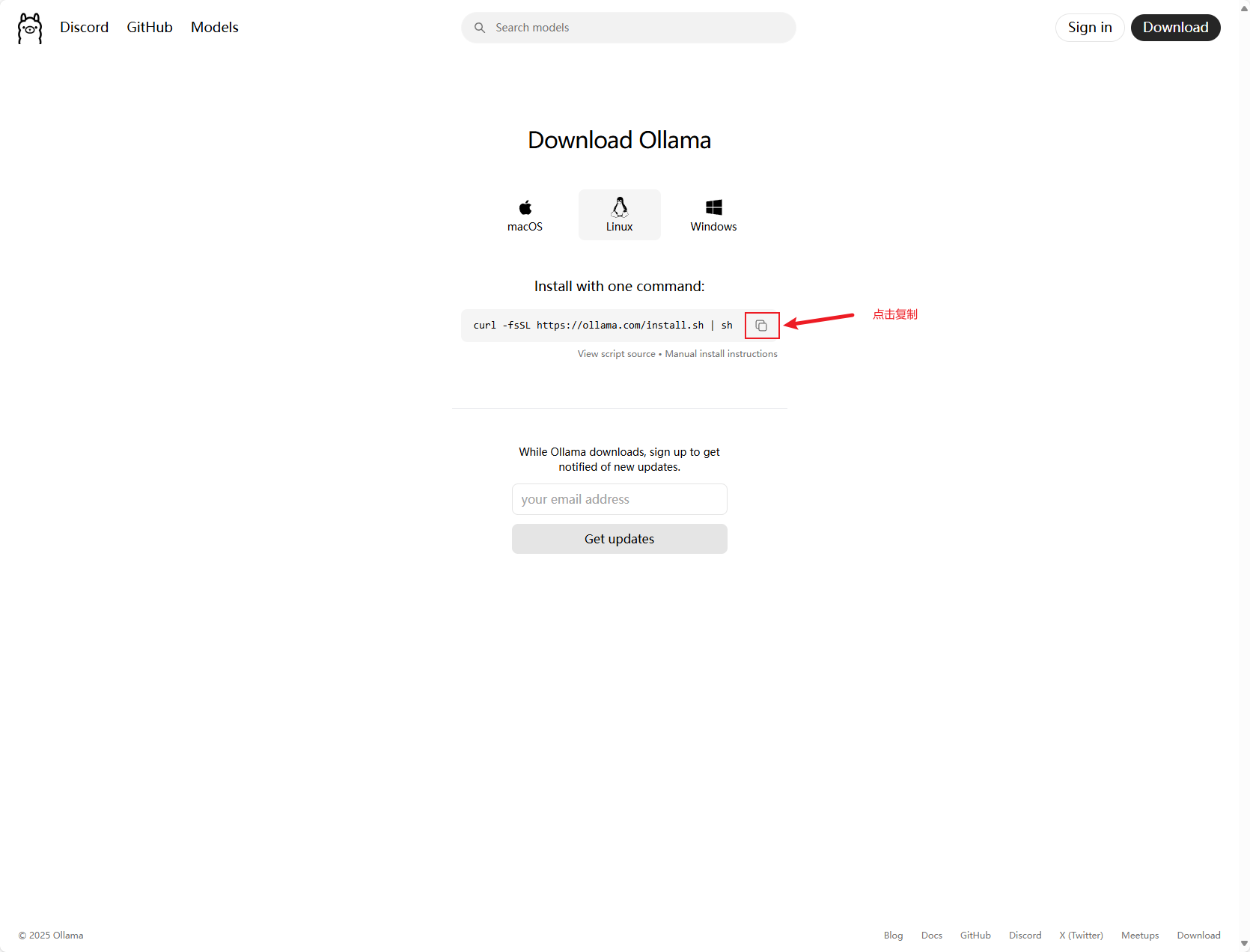

1. ollama官网地址Ollama

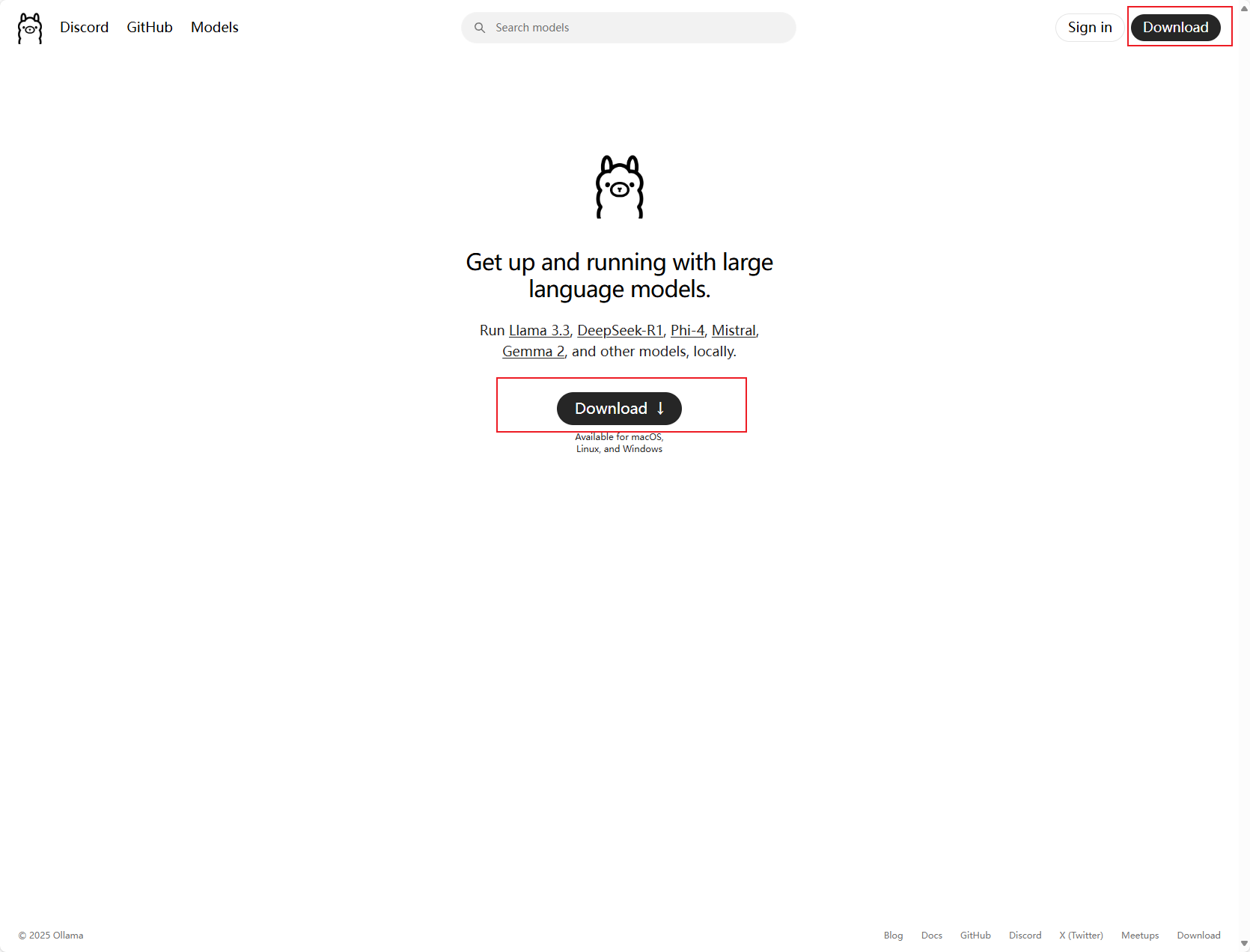

2.ollama下载

根据自己需要部署的操作系统选择

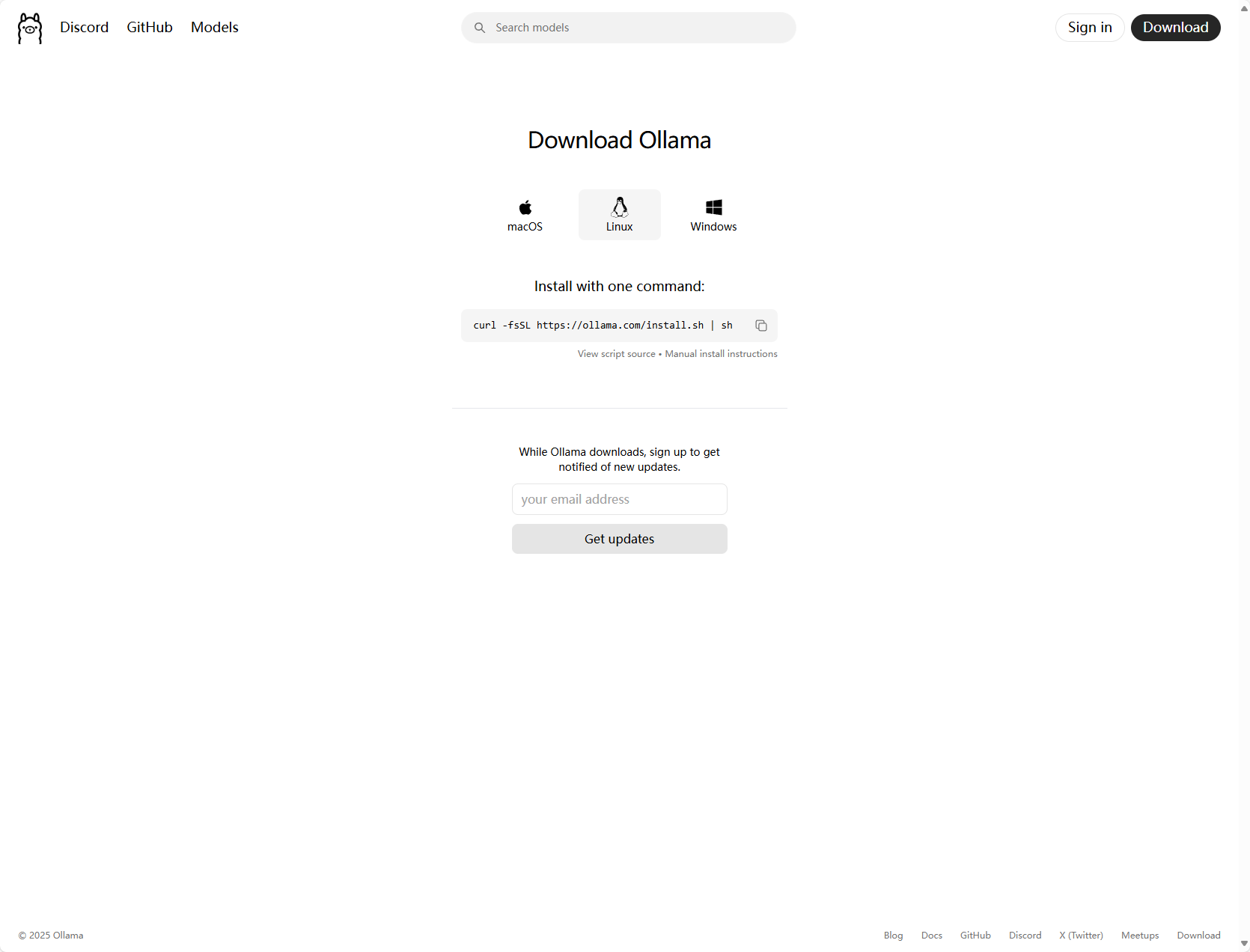

3.Linux操作系统安装(此处以Rocky Linux v9.5为例)

下载ollama

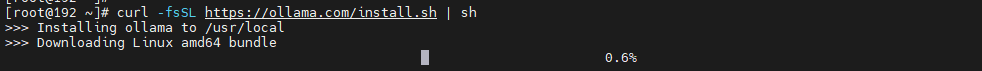

执行复制命令,等待下载和安装结束

curl -fsSL https://ollama.com/install.sh | sh

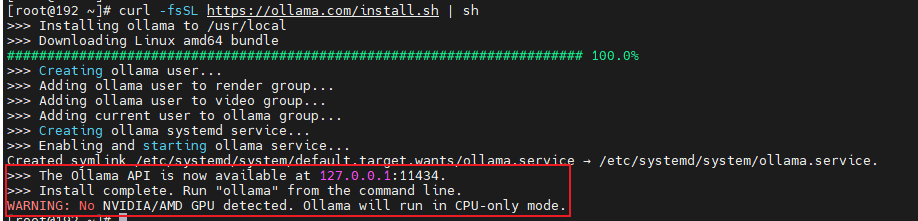

安装结束后会出现如下内容,说明已经安装完成

⚠️⚠️⚠️由于本猿使用的linux服务器没有安装显卡(GPU),所以会出现如下的警告

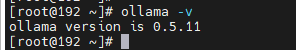

校验是否安装成功

# 打开cmd命令行界面,快捷键 Win+R ollama -v执行后会看到如下的结果

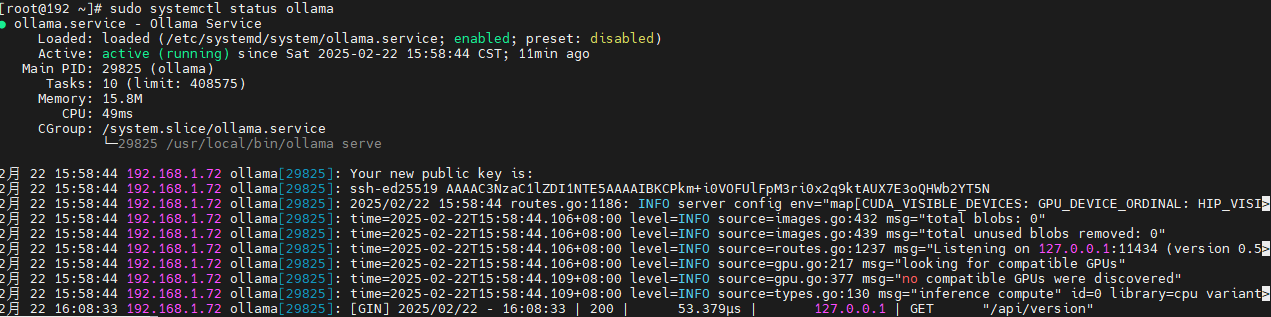

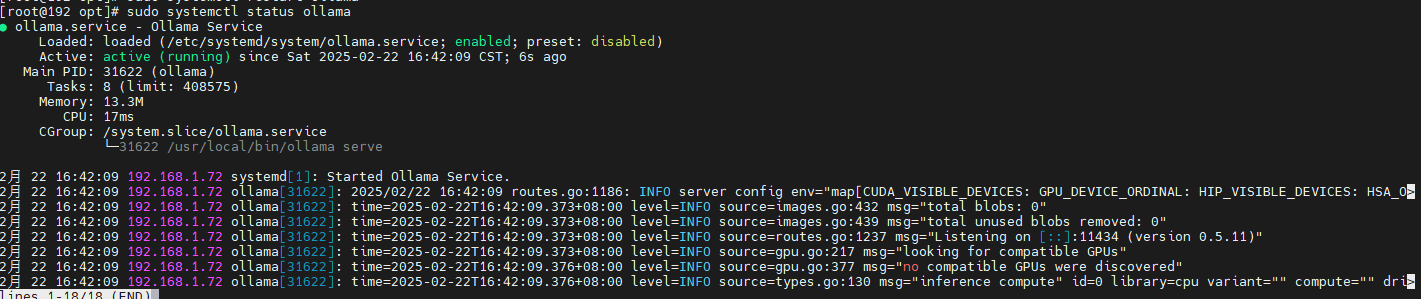

# 输入如下命令查看是否正常运行 sudo systemctl status ollama出现如下结果则说明正常运行

修改模型保存路径(根据自己的目录空间大小决定,如果空间足够充足可以不进行调整)

编辑ollama.service文件

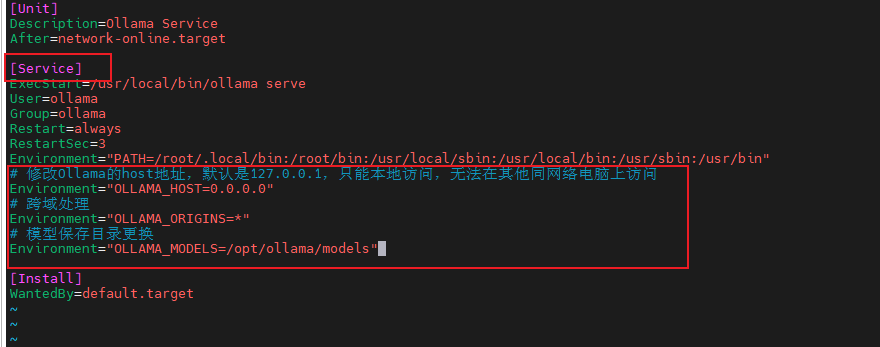

# 编辑/etc/systemd/system/ollama.service文件 sudo vim /etc/systemd/system/ollama.service在[Service]标记下,添加如下内容,如下图所示(如果实在不理解什么涵义,直接添加下面内容就可以)

模型变更文件夹创建

# 执行命令创建自定义模型保存目录 sudo mkdir -p /opt/ollama/models根据需求添加模型文件保存路径配置

# 修改Ollama的host地址,默认是127.0.0.1,只能本地访问,无法在其他同网络电脑上访问 Environment="OLLAMA_HOST=0.0.0.0" # 跨域处理 Environment="OLLAMA_ORIGINS=*" # 模型保存目录更换,此处/opt/ollama/models文件夹根据自己需求变化创建,如果不需要变更模型保存文件夹,则不需要配置 Environment="OLLAMA_MODELS=/opt/ollama/models"

保存该文件内容

# 按下Esc键 # 同时按下`Shift`和`:` # 输入wq回车 wq

重新加载刷新配置

# 刷新配置 sudo systemctl daemon-reload重启ollama

# 重启ollama sudo systemctl restart ollama如果需要每次系统重启,ollama随机启动运行,在执行如下命令

# 配置Ollama服务随机启动 sudo systemctl enable ollama校验是否重启成功

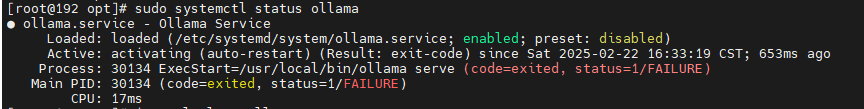

sudo systemctl status ollama如果出现如下情况,则说明失败

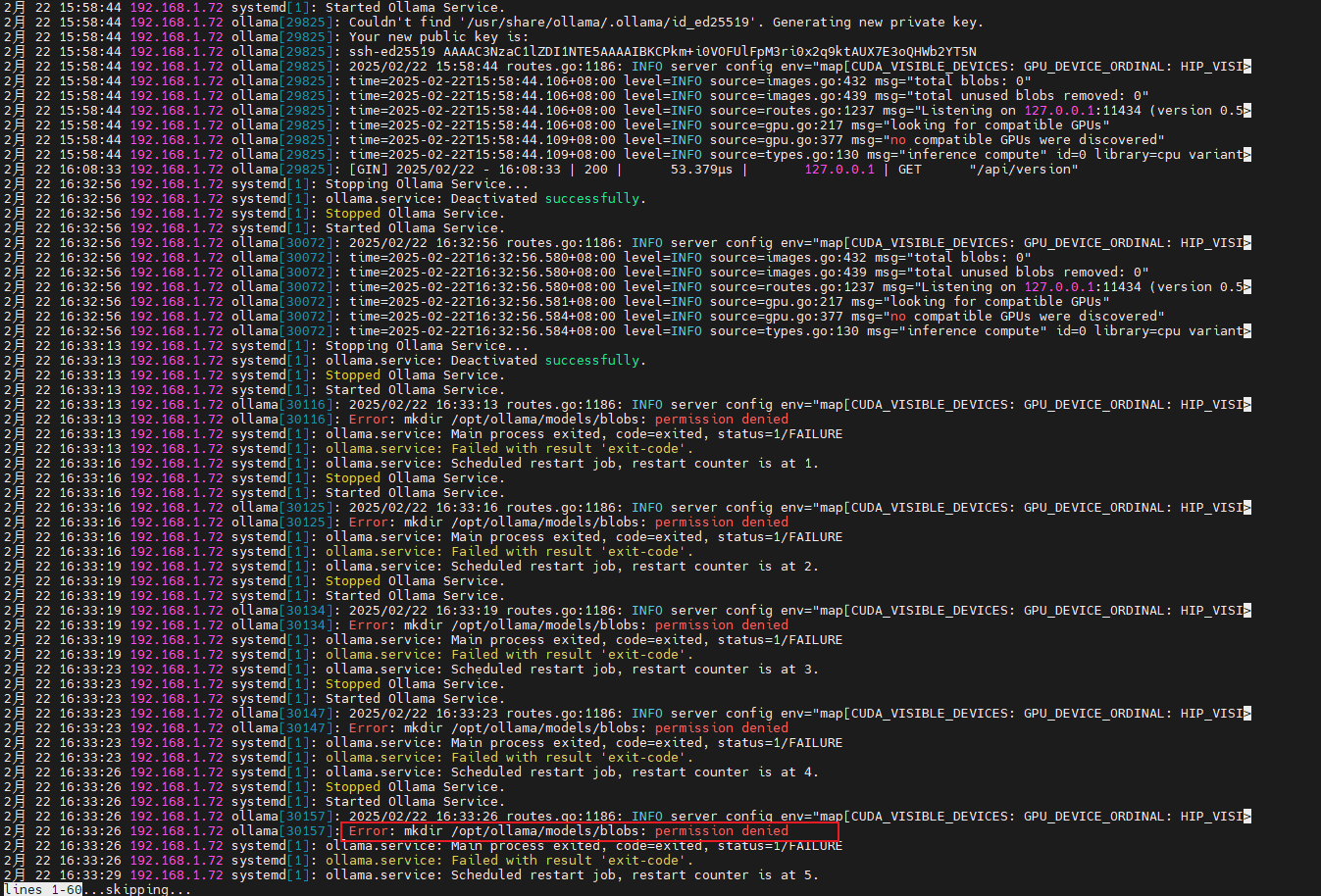

# 执行如下命令,检查服务启动失败原因 sudo journalctl -u ollama我们会发现此处提示报错原因是没有权限在之前创建的模型的目录下创建文件夹

给创建的模型文件夹授权

# 将目标路径的所属用户和组改为root用户 sudo chown -R root:root /opt/ollama/models # 将文件夹权限更换为777 sudo chmod -R 777 /opt/ollama/models # 再次执行如下重启命令 sudo systemctl restart ollama # 查看启动状态 sudo systemctl status ollama如果出现如下情况,则说明启动成功

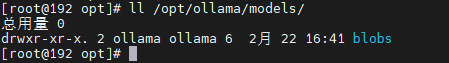

检验模型目录是否切换成功

# 执行如下命令查看是否生成blobs文件夹 sudo ll /opt/ollama/models

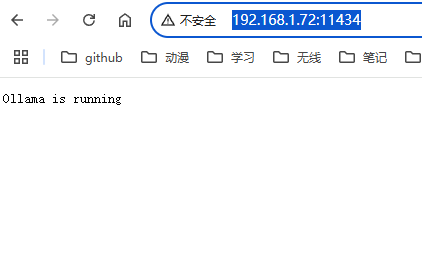

同局域网访问,检验是否可以,在另一台电脑浏览器中访问http://192.168.1.72:11434/,地址根据自己服务器地址更换

如果出现如下界面,则说明可以访问成功

如果还是不可以,请检查是否服务器防火墙没有开放该端口

本猿使用的服务器操作系统(Rocky Linux v9.5)端口开放方法如下:

# 开放端口 sudo firewall-cmd --zone=public --permanent --add-port=11434/tcp # 刷新系统配置,使其生效 sudo firewall-cmd --reload

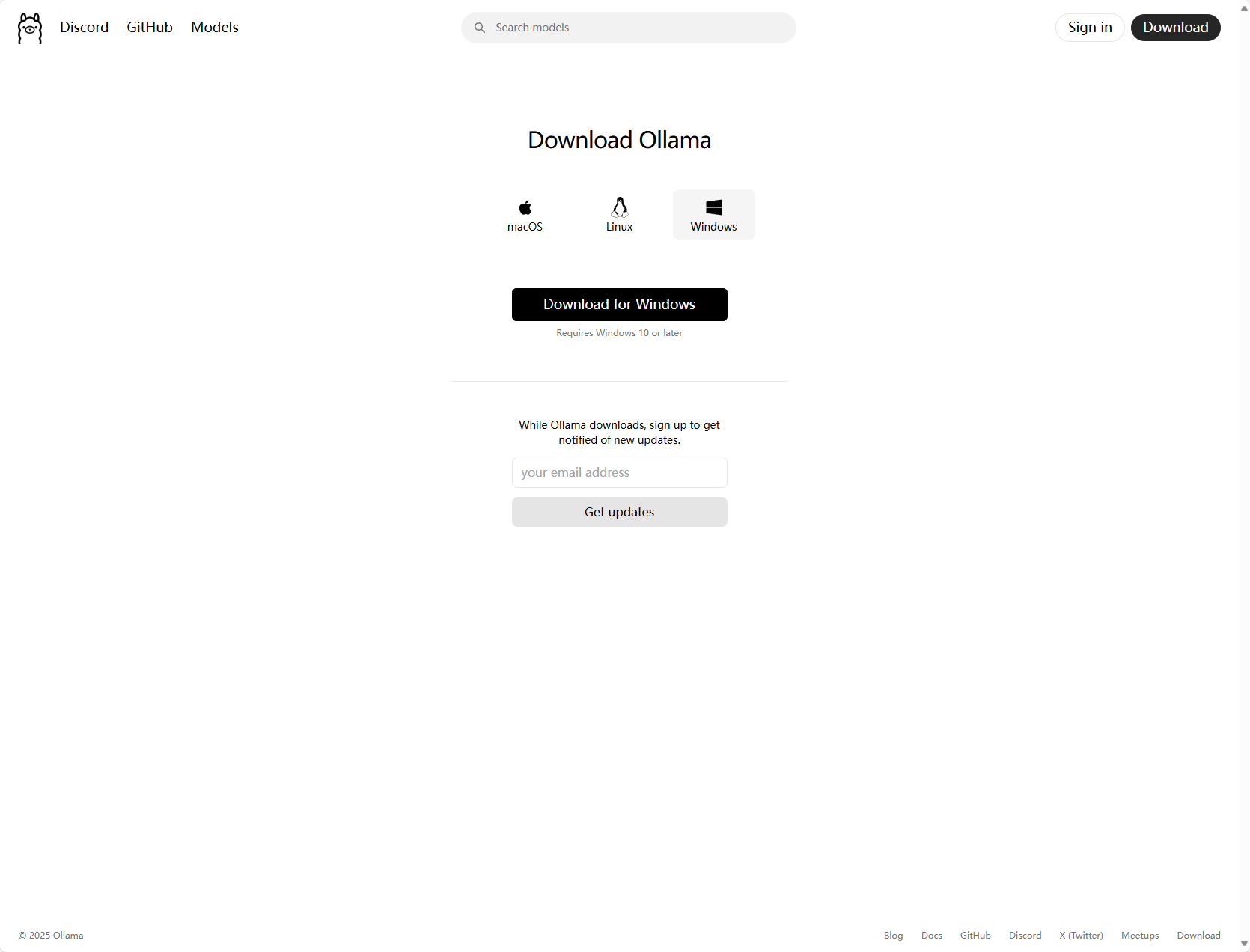

4.Windows操作系统安装

下载ollama

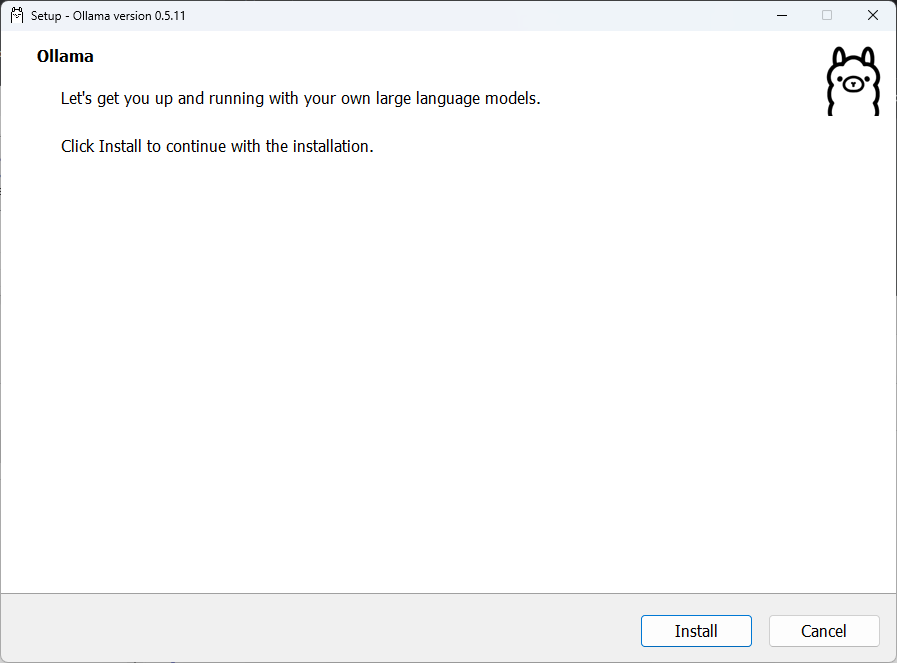

双击OllamaSetup.exe文件安装,会出现如下界面

点击Install进行安装

🎗️🎗️🎗️说明:

此处无法选择安装目录,默认安装路径为 C:\Users\

用户名\AppData\Local\Programs此处

用户名根据用户具体的计算机名称调整校验是否安装成功

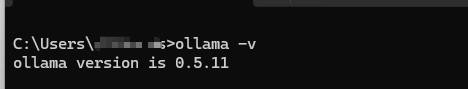

# 打开cmd命令行界面,快捷键 Win+R ollama -v看到如下结果说明ollama已经安装成功

或者查看任务栏中是否存在如下图标,如果存在说明安装成功

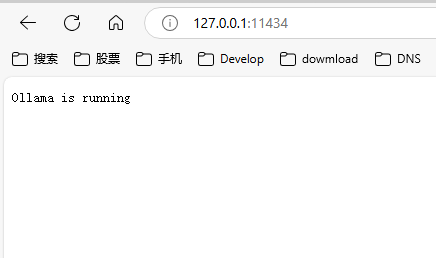

也可以在浏览器中输入如下地址http://127.0.0.1:11434/访问,出现如下内容说明安装成功

修改模型保存路径(根据自己的目录空间大小决定,如果空间足够充足可以不进行调整)

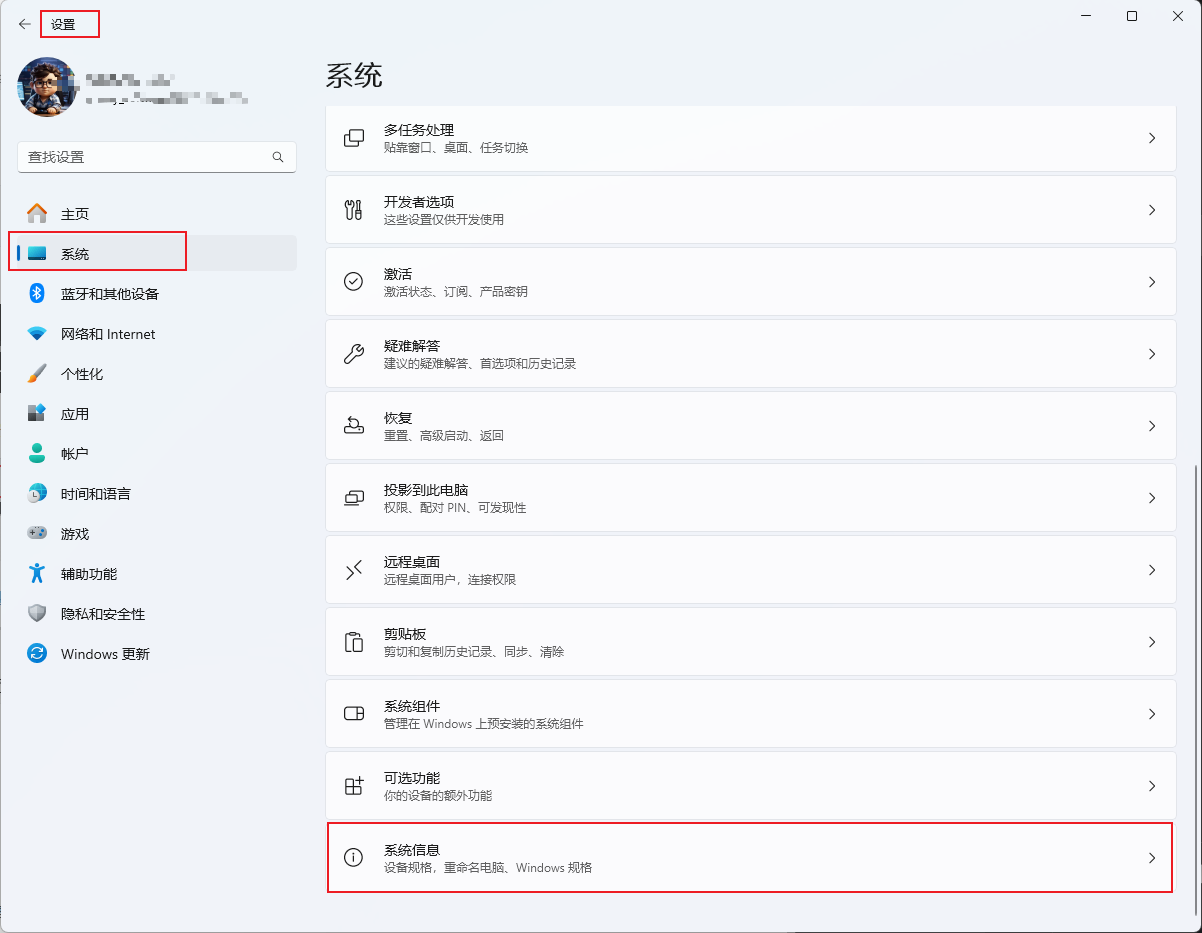

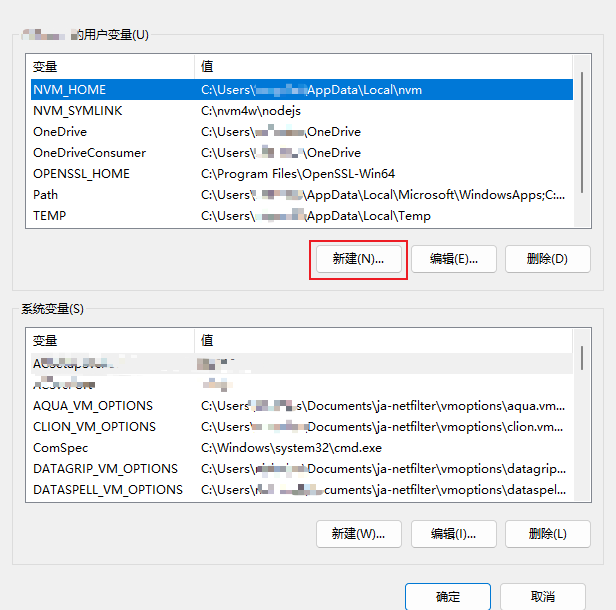

- 进入系统设置界面,滚动页面翻到最下方,选择系统信息

选择高级系统设置

点击环境变量

新建用户环境变量

添加环境变量信息,然后一路确定下去就可以了

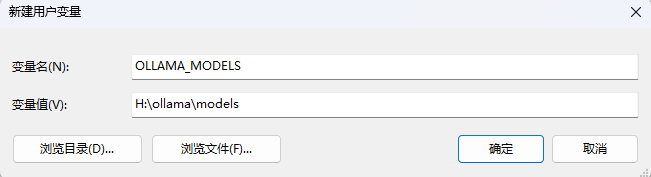

🎗️🎗️🎗️说明:

- 模型路径修改,配置内容如下:

- 变量名:OLLAMA_MODELS

- 变量值:H:\ollama\models(根据自己的目录更换,此处是本猿使用的路径)

- 如果还需要给局域网其他电脑使用,需要添加如下两个配置

- 添加OLLAMA_HOST

- 变量名:OLLAMA_HOST

- 变量值:0.0.0.0

- 添加OLLAMA_ORIGINS

- 变量名:OLLAMA_ORIGINS

- 变量值:*

- 添加OLLAMA_HOST

- 模型路径修改,配置内容如下:

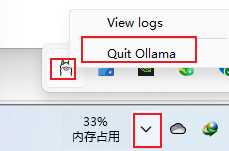

重启ollama工具,在任务中找到ollama图标,然后右击鼠标右键,点击Quit Ollama

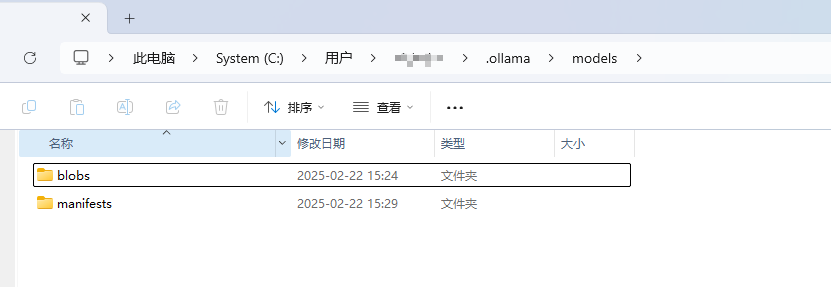

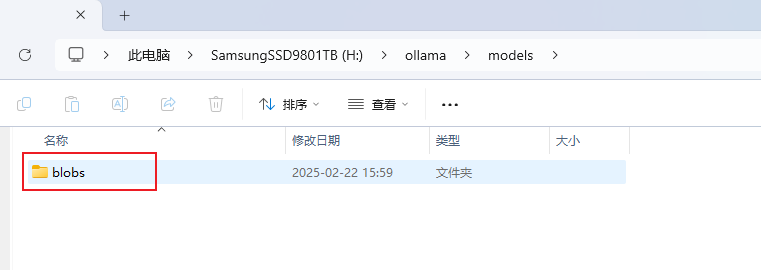

检查模型保存文件目录是否变更

ollama原默认模型保存路径C:\Users\用户名\.ollama\models

修改后会发现,在更换的目录下多了一个blobs文件夹,说明已经更换成功

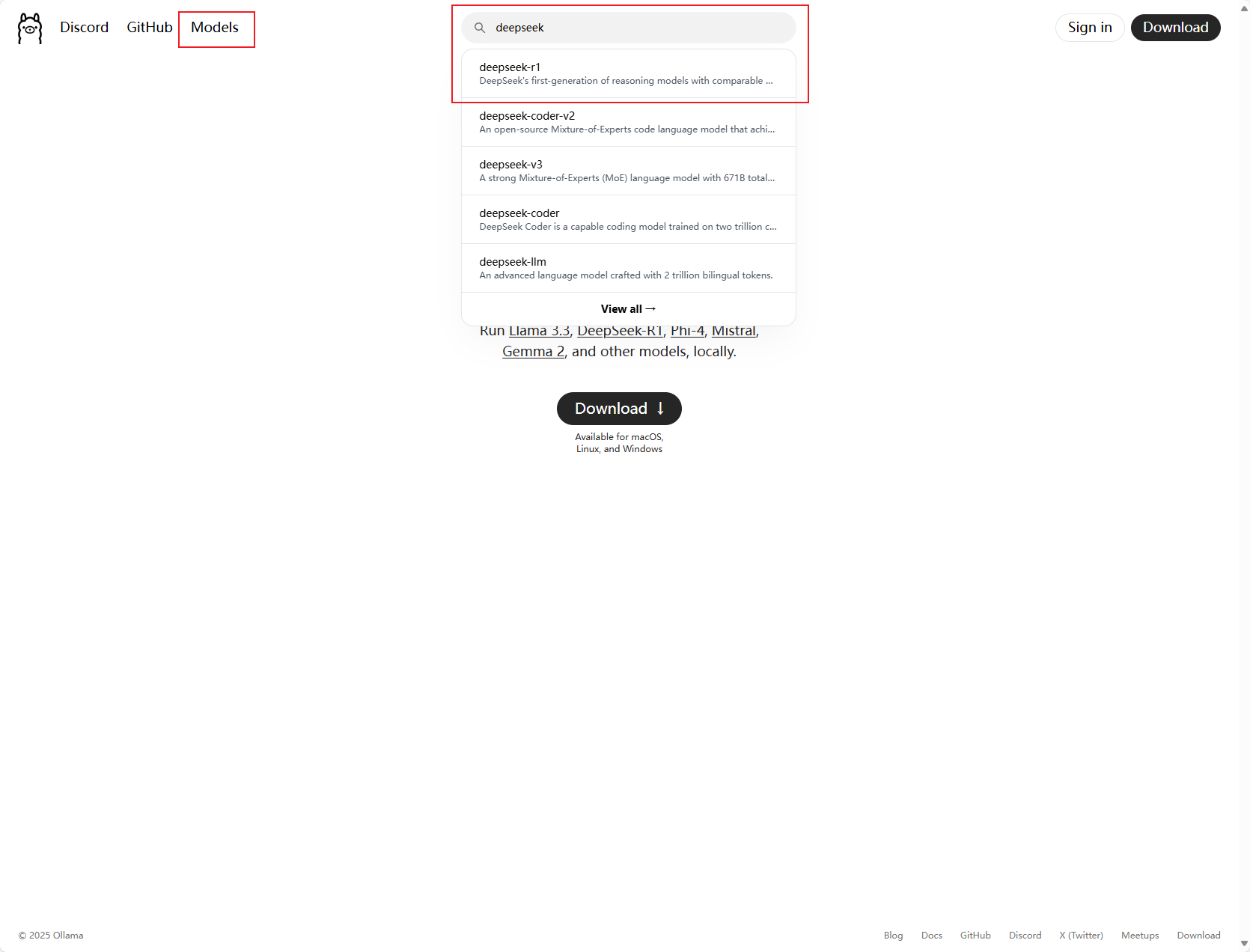

5.模型下载

下载模型,此处以deepseek r1 7B为例

首先到ollama官方查找模型

此处我们选择deepseek-r1

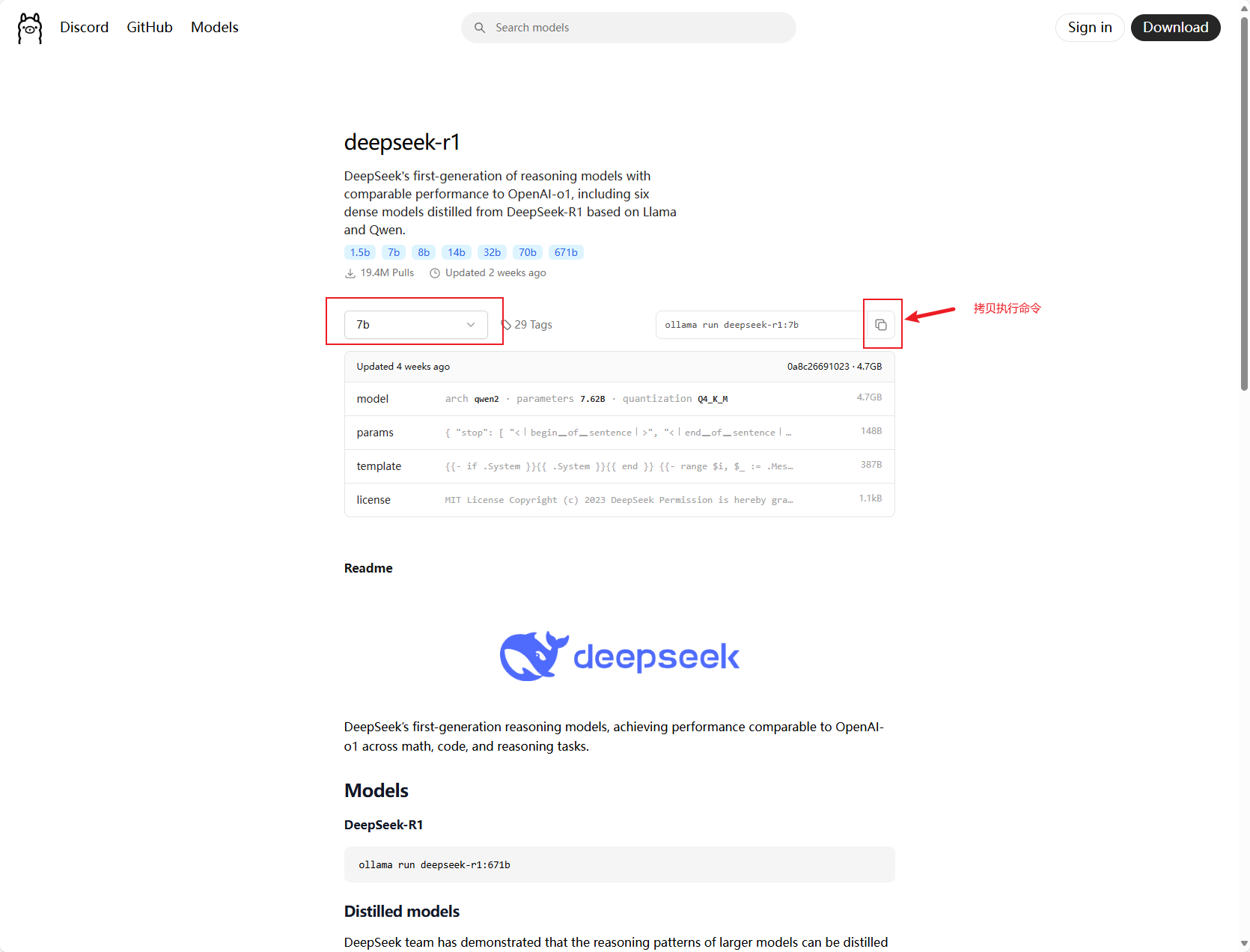

官方提供的命令是直接下载并运行模型

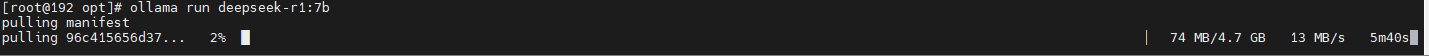

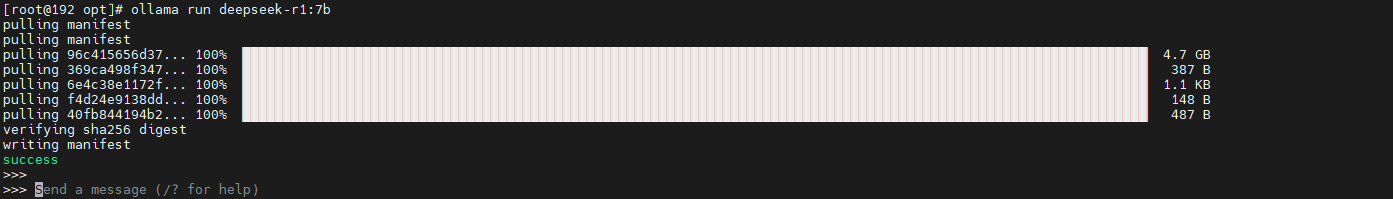

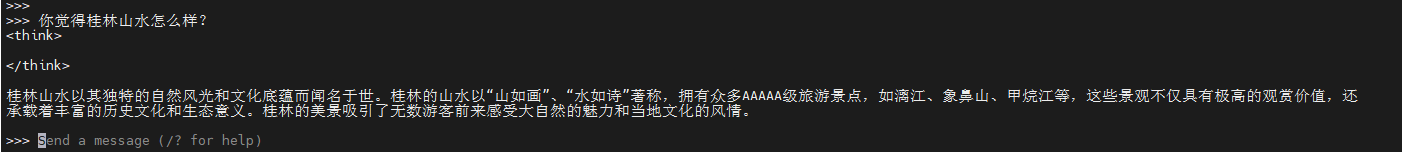

ollama run deepseek-r1:7b下载模型状态如下

下载完成自动运行模型

进行提问

如果想不直接运行仅拉取下载模型,执行如下命令

ollama pull deepseek-r1:7b

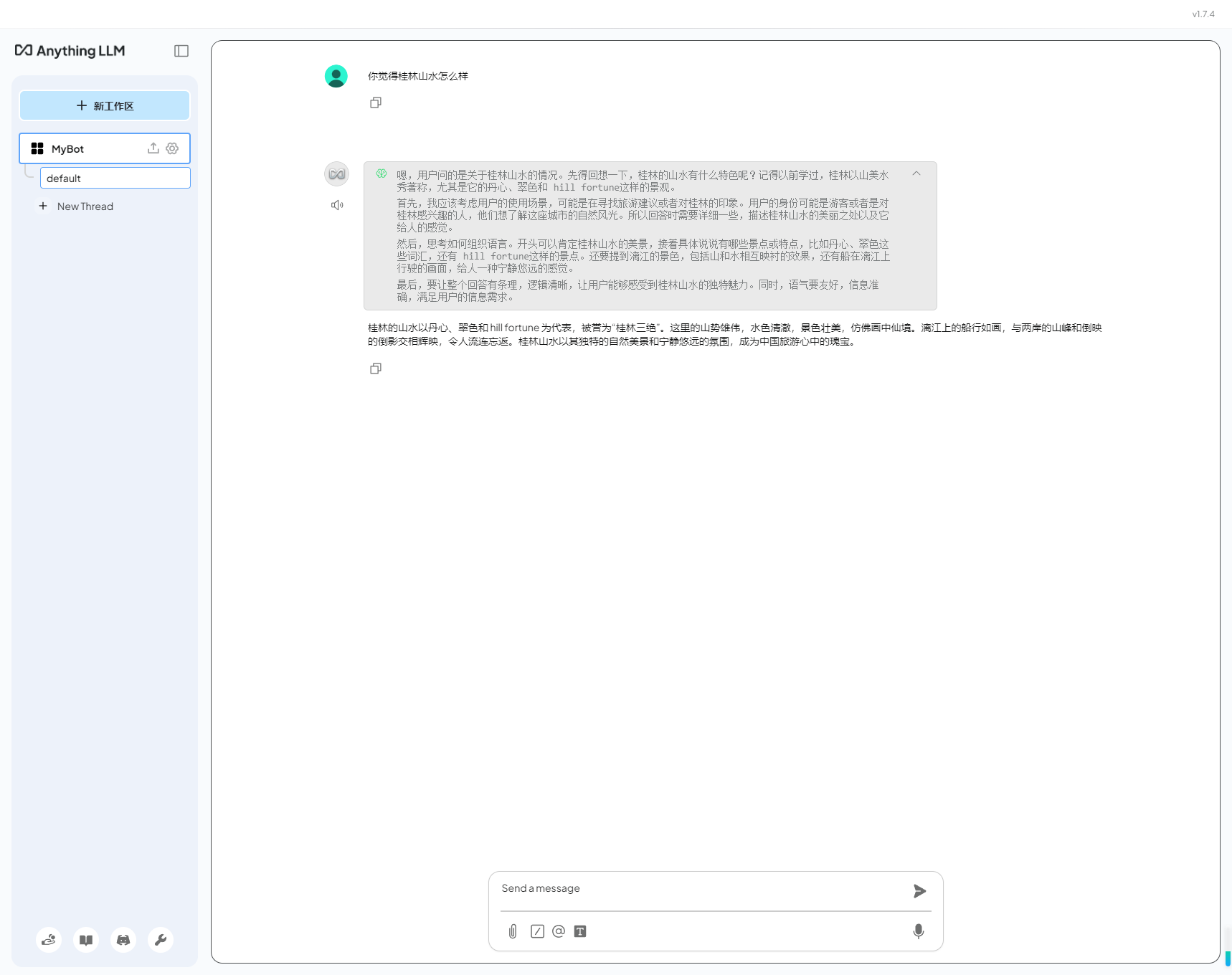

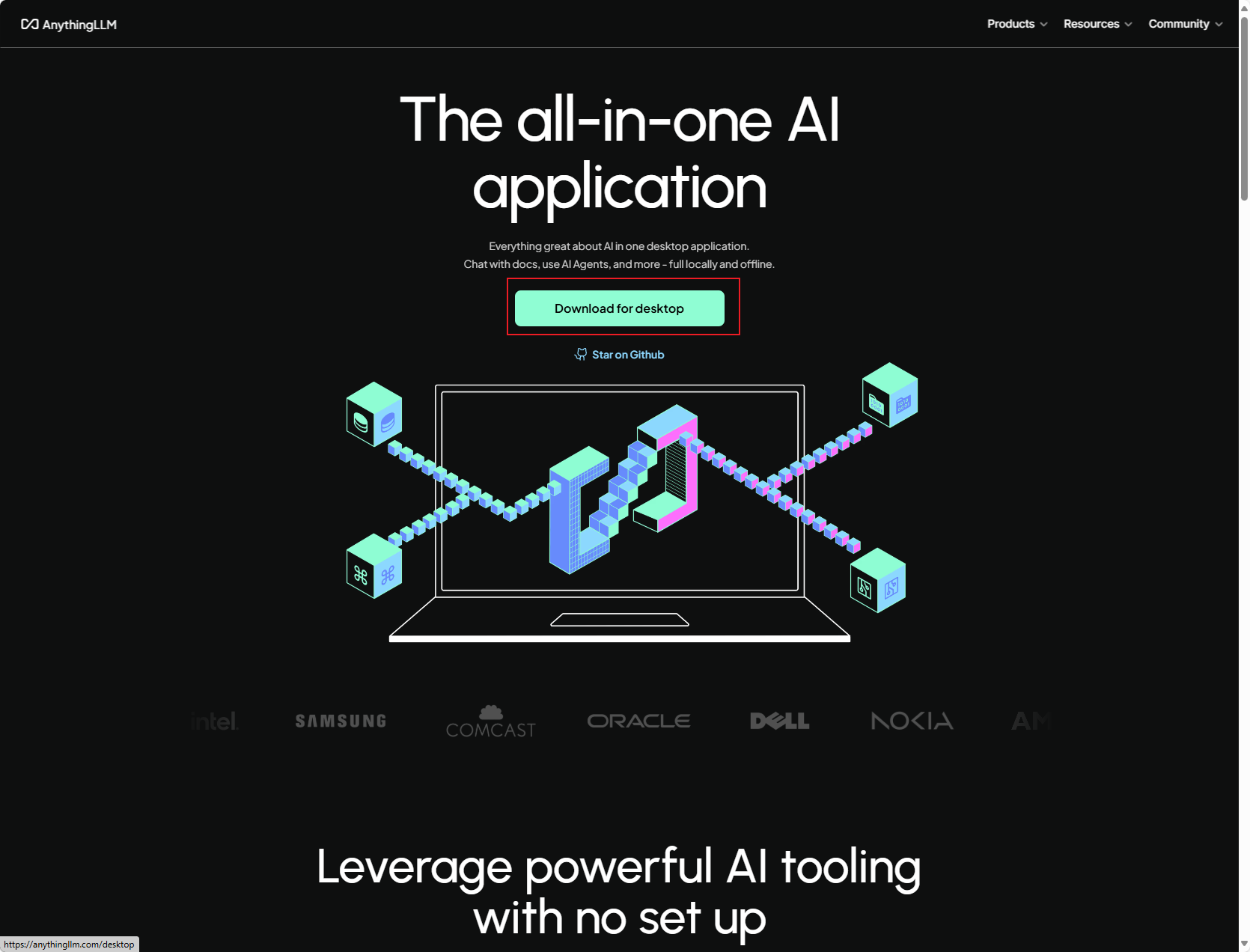

5.使用图形化界面访问部署好的模型,此处使用AnythingLLM

- 下载AnythingLLM,https://anythingllm.com/

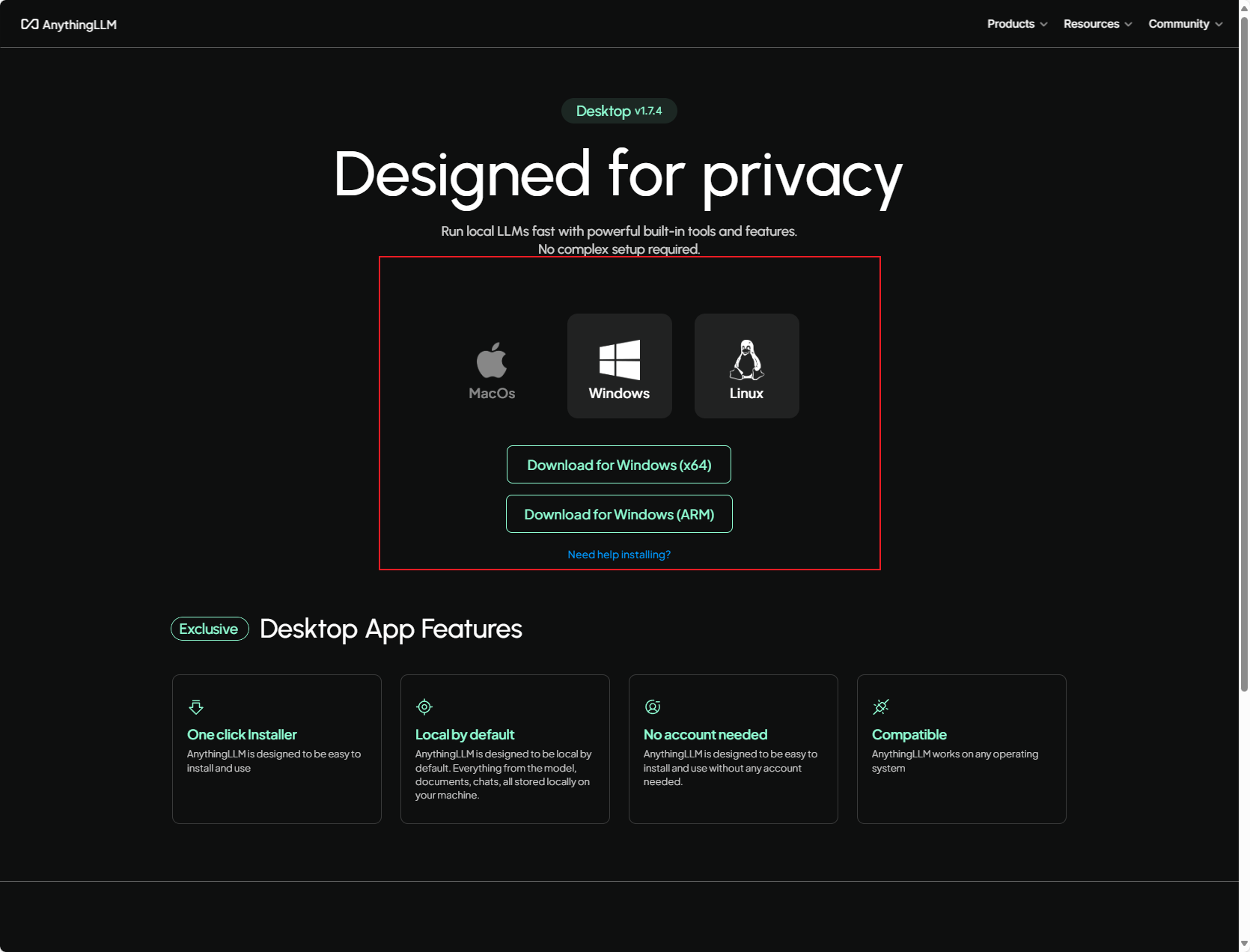

根据自己的电脑系统选择适合的安装包

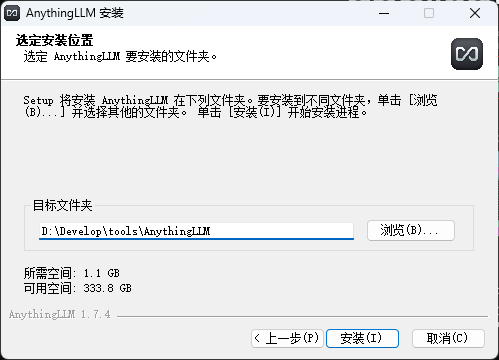

双击AnythingLLMDesktop.exe进行安装,根据自己喜好选择安装目录

配置AnyThingLLM

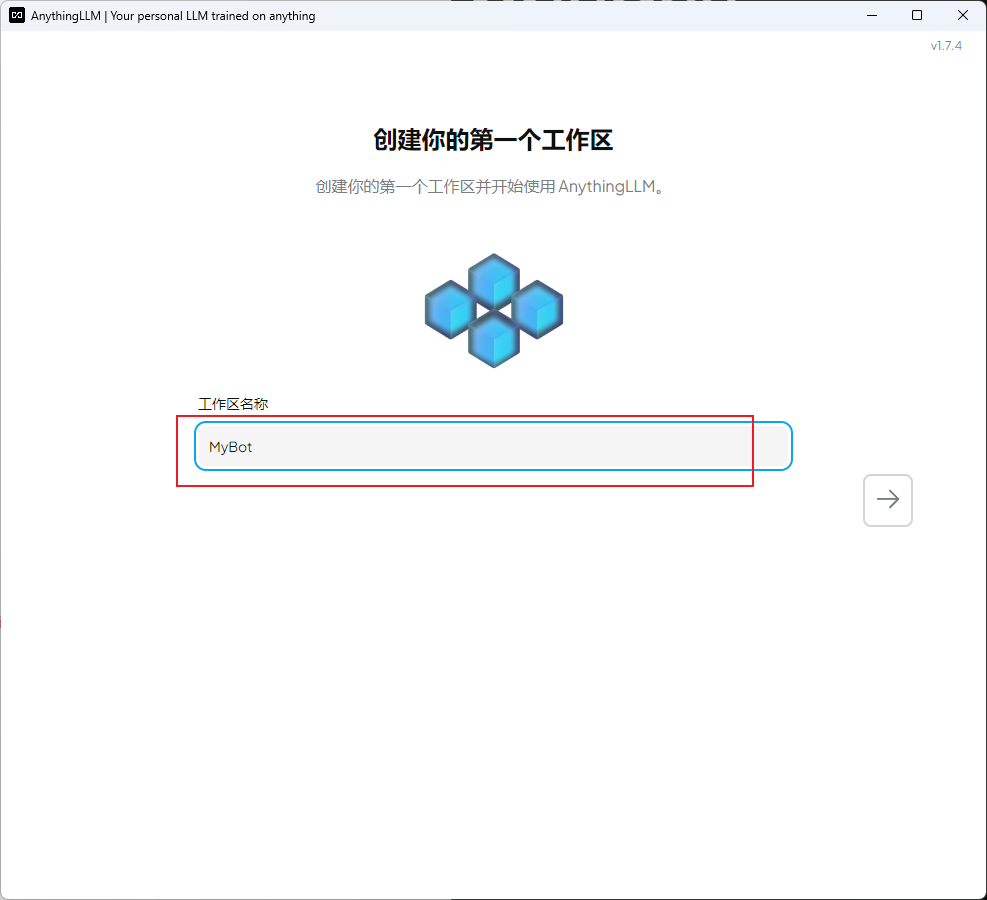

创建工作区

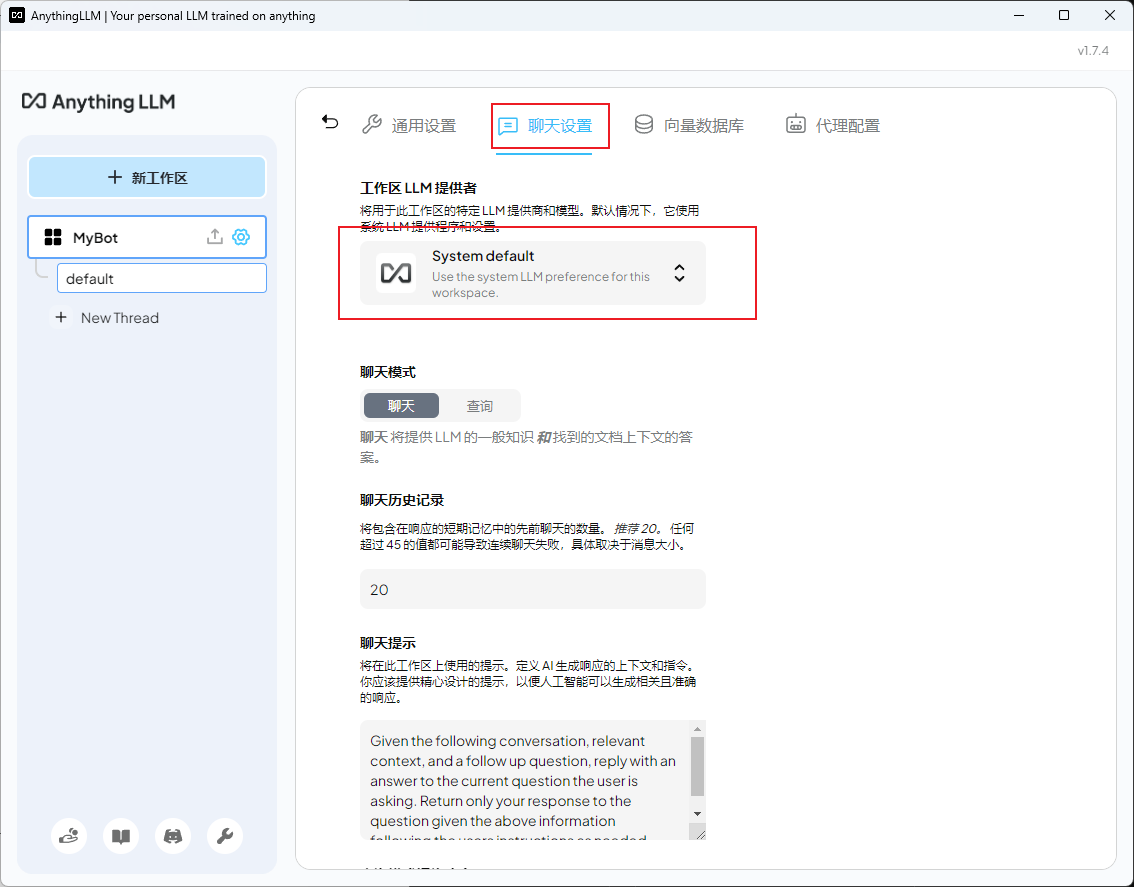

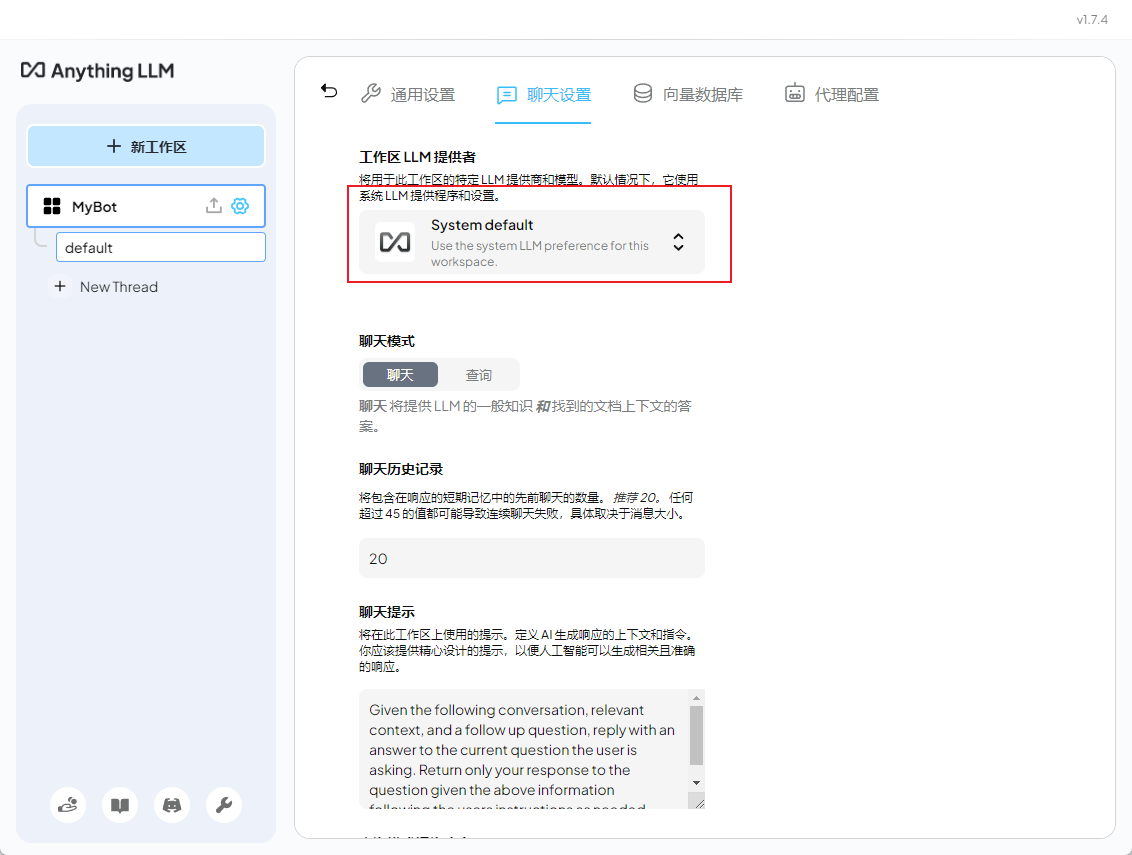

配置模型连接方式以及默认使用什么模型

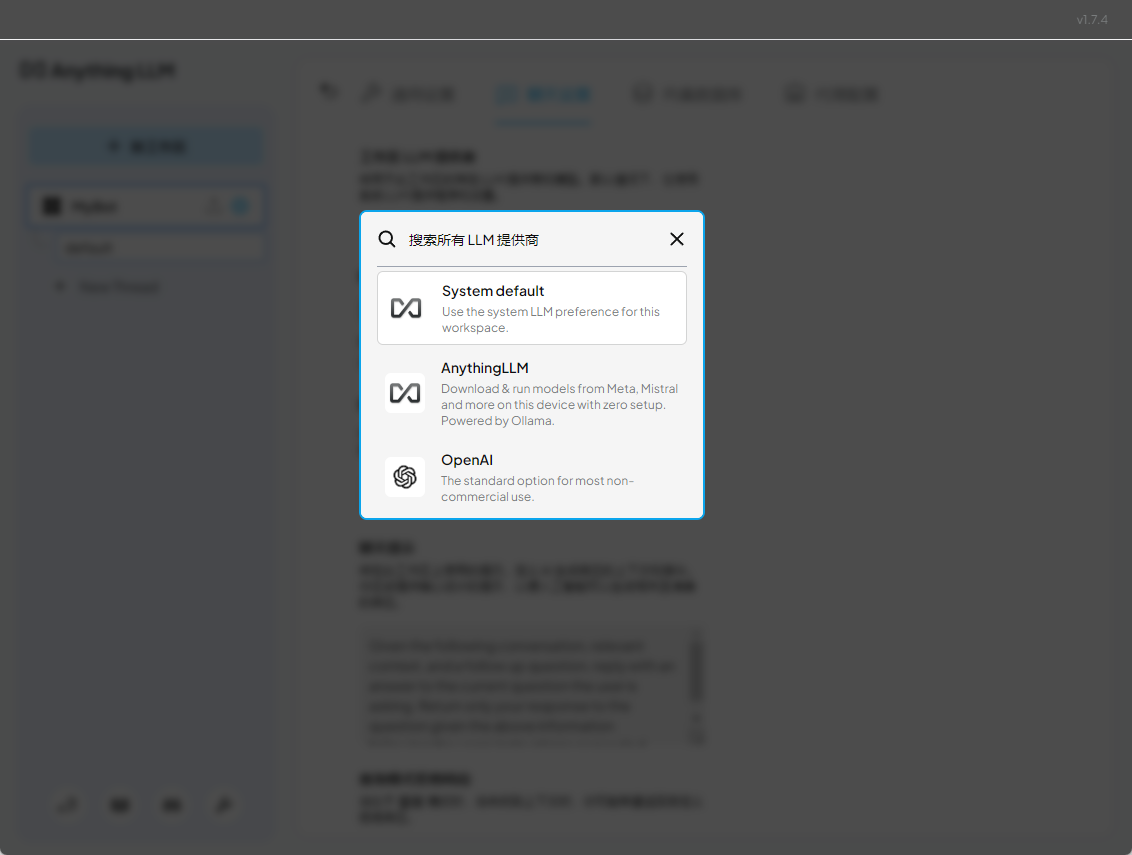

选择聊天设置

选择工作区LLM提供者

选择提供商

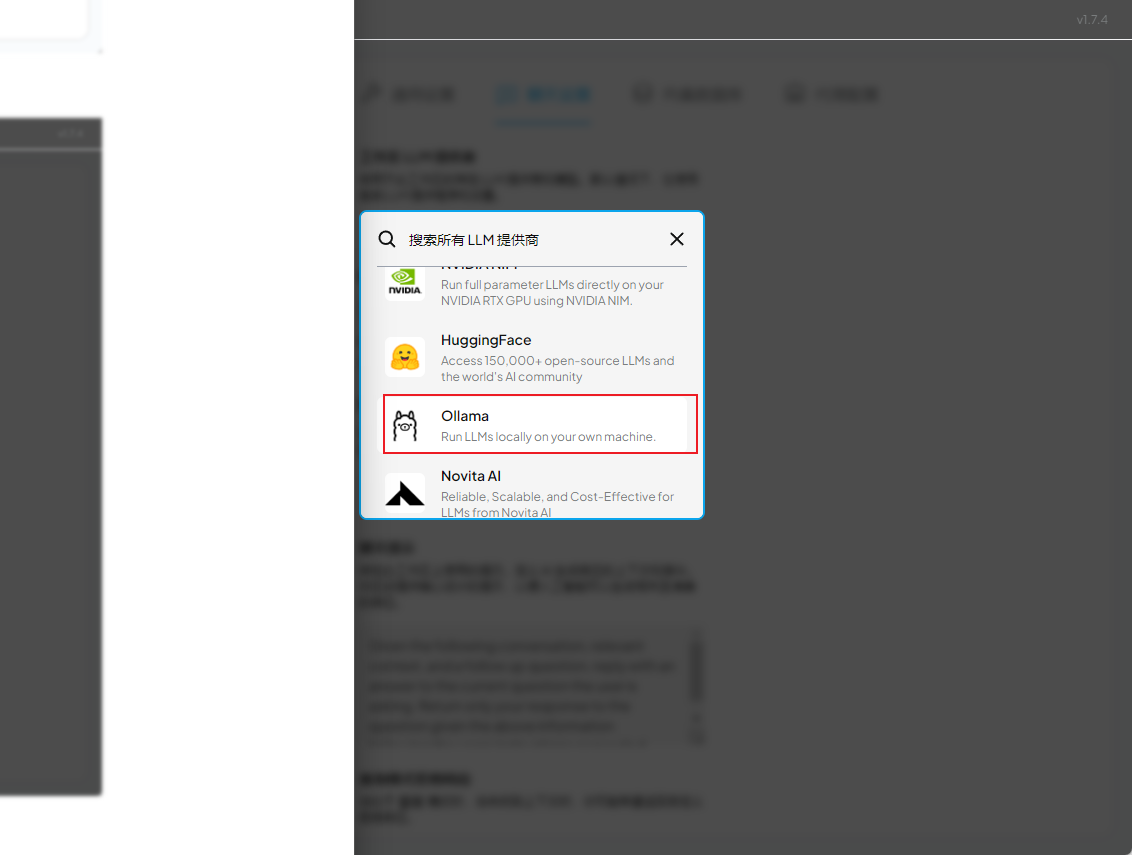

在列表中选择Ollama

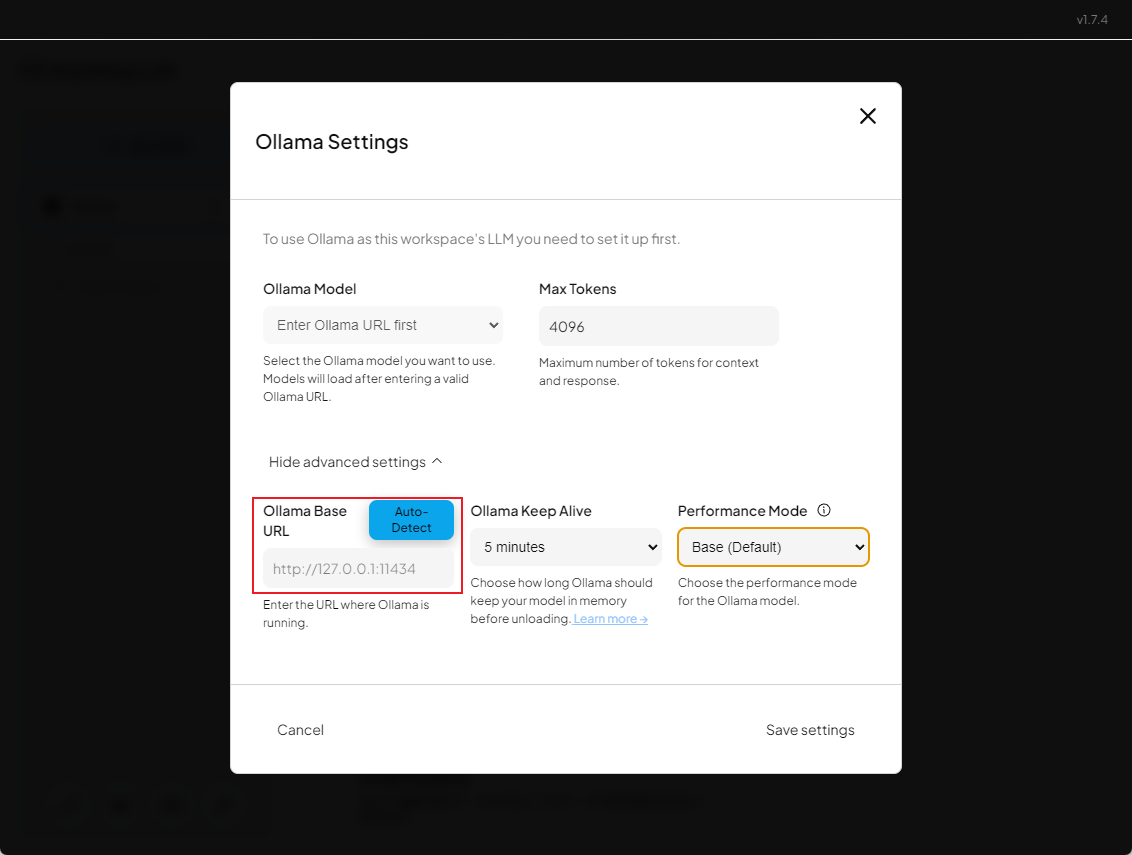

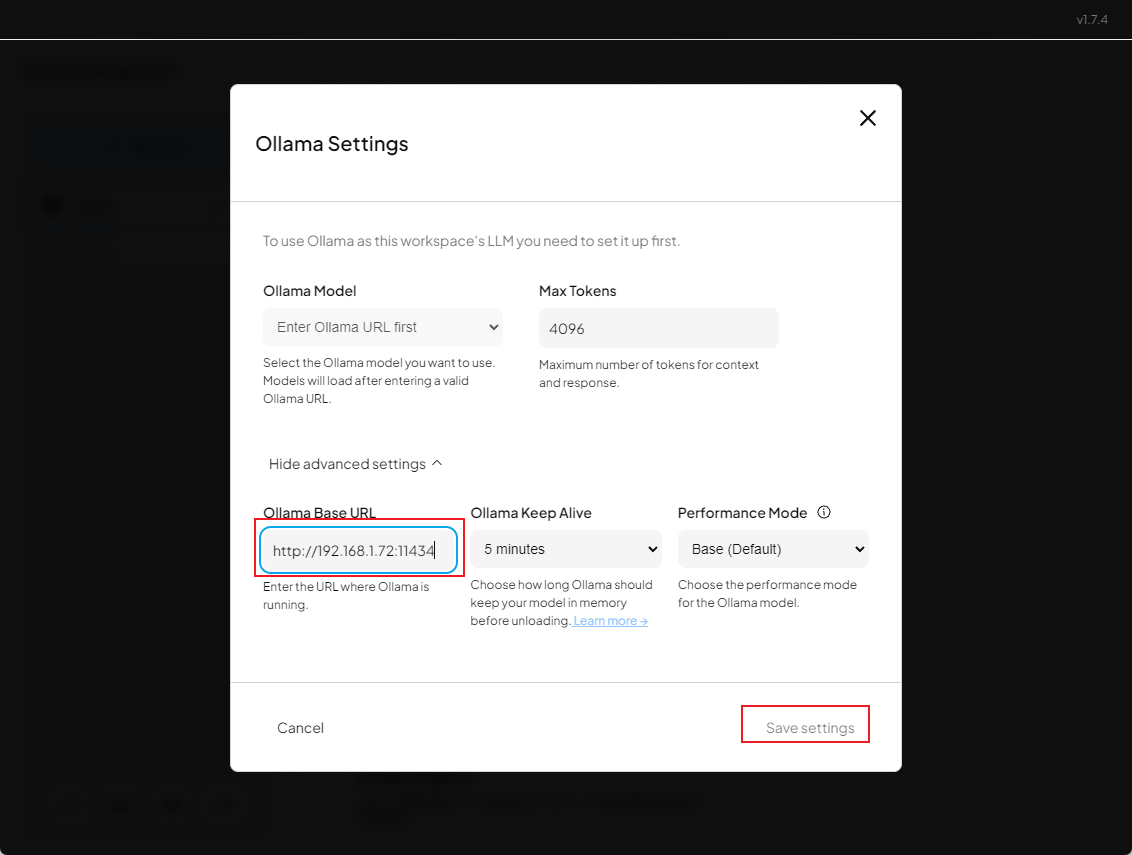

配置Ollama服务连接地址

此处地址根据实际情况选择

- 如果是本地服务(AnythingLLM工具和Ollama在同一台电脑上),填入http://127.0.0.1:11434

- 如果是非本地服务(AnythingLLM工具和Ollama不在同一台电脑上),填入http://服务器IP:11434

此处本猿以服务器部署的地址来配置

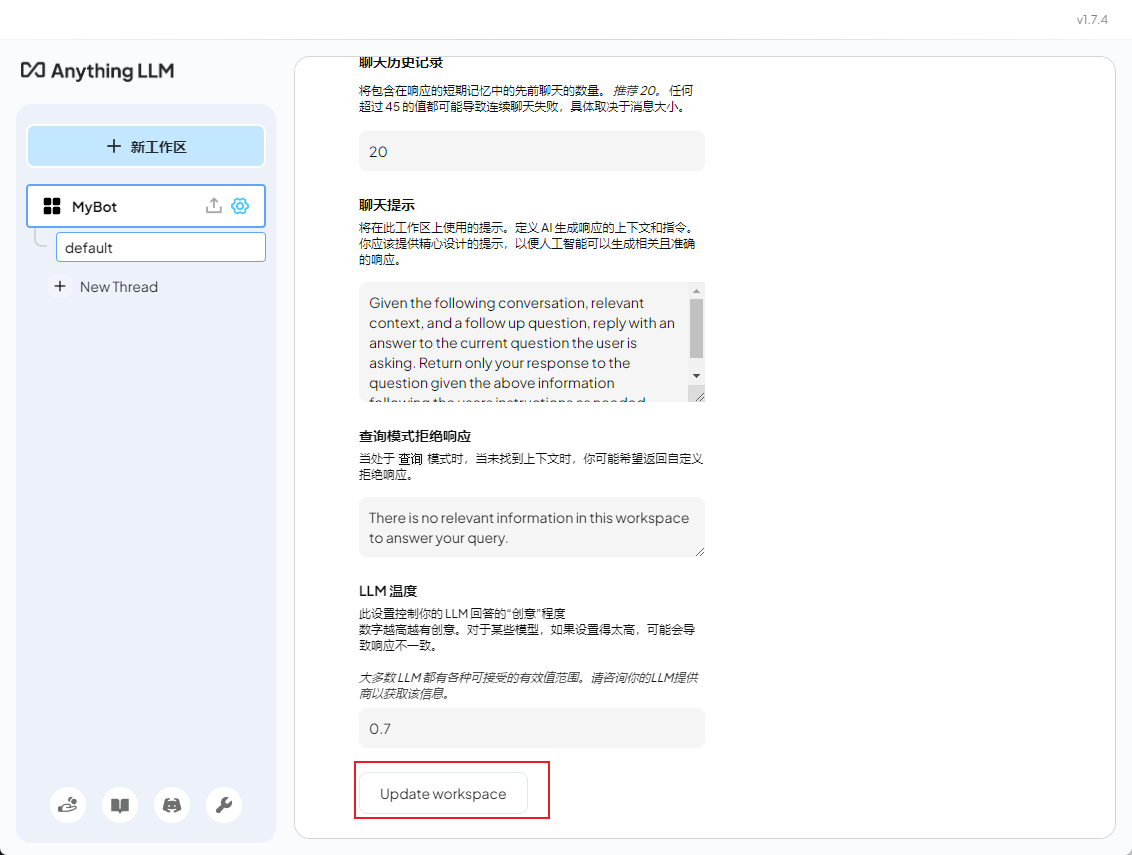

配置页翻到最下方,更新工作区配置

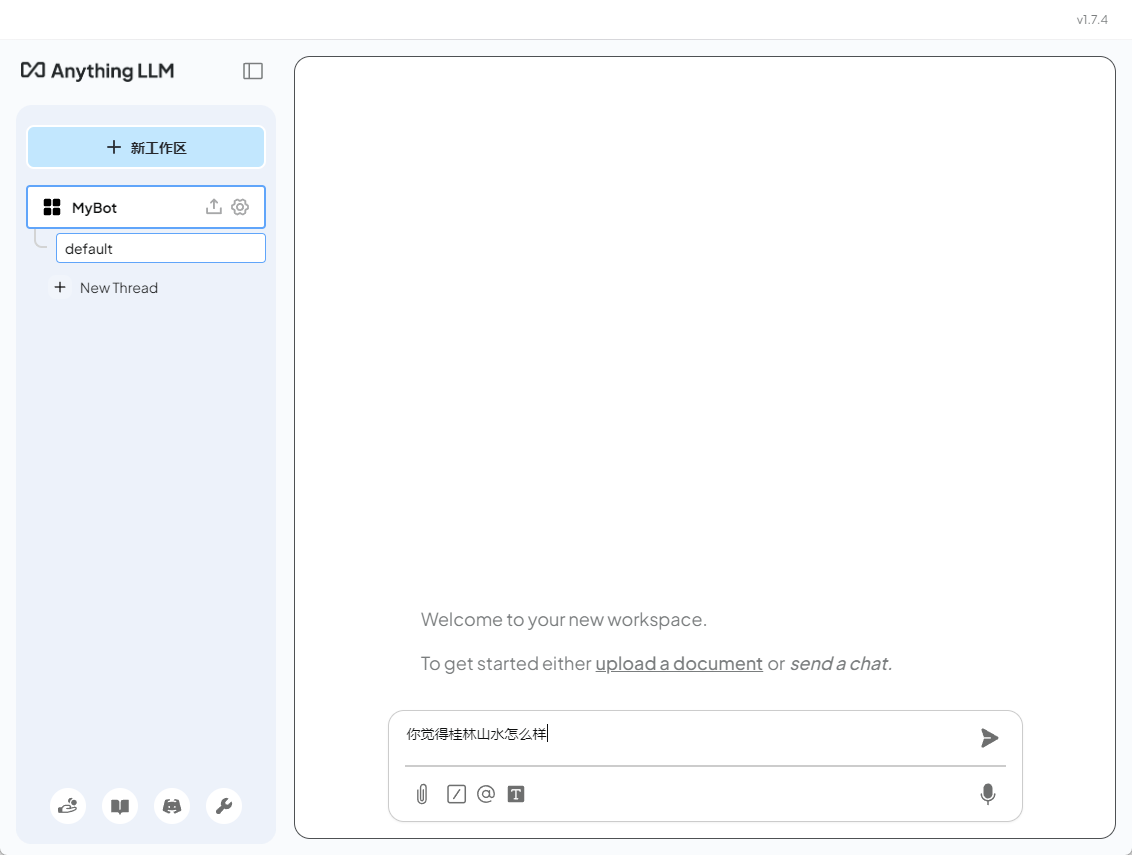

回到工作区界面

输入聊天内容进行聊天

结果反馈